یادگیری بدون ناظر (بدون سرپرست) چیست؟

یادگیری بدون ناظر یا بدون سرپرست (Unsupervised Learning)، یا یادگیری ماشین بدون ناظر، از الگوریتمهای یادگیری ماشین برای تجزیه و تحلیل و خوشهبندی مجموعه دادههای بدون برچسب استفاده میکند. این الگوریتمها الگوهای پنهان یا گروهبندی دادهها را بدون نیاز به دخالت انسان کشف میکنند. توانایی آن در کشف شباهتها و تفاوتها در اطلاعات، آن را به راه حلی ایدهآل برای تجزیه و تحلیل دادههای اکتشافی، استراتژیهای فروش متقابل، تقسیمبندی مشتری و تشخیص تصویر تبدیل میکند.

روشهای رایج یادگیری بدون ناظر

مدلهای یادگیری بدون ناظر برای سه کار اصلی خوشهبندی (Clustering)، وابستگی (Association) و کاهش ابعاد (Dimentionality Reduction) مورد استفاده قرار میگیرند. در زیر هر روش یادگیری را تعریف میکنیم و الگوریتمها و رویکردهای رایج را برای اجرای موثر آنها برجسته میکنیم.

خوشهبندی

خوشهبندی یک تکنیک دادهکاوی است که دادههای بدون برچسب را بر اساس شباهتها یا تفاوتهای آنها گروهبندی میکند. الگوریتمهای خوشهبندی برای پردازش اشیاء، دادههای خام و طبقهبندینشده به گروههایی استفاده میشود که توسط ساختارها یا الگوهای موجود در اطلاعات نمایش داده میشوند. الگوریتمهای خوشهبندی را میتوان به چند نوع انحصاری، دارای همپوشانی، سلسلهمراتبی و احتمالی دستهبندی کرد.

خوشهبندی انحصاری و دارای همپوشانی

خوشهبندی انحصاری (Exclusive Clustering) شکلی از گروهبندی است که تصریح میکند یک نقطهی داده میتواند فقط در یک خوشه وجود داشته باشد. این را میتوان خوشهبندی “سخت” هم نامید. الگوریتم خوشهبندی K-means نمونهای از خوشهبندی انحصاری است.

- خوشهبندی K-means نمونهای رایج از یک روش خوشهبندی انحصاری است که در آن نقاط داده به K گروه اختصاص داده میشوند، که در آن K تعداد خوشهها را بر اساس فاصله از مرکز هر گروه نشان میدهد. نزدیکترین نقاط داده به یک مرکز دسته در همان دسته قرار میگیرند. مقدار Kی بزرگتر نشاندهنده گروهبندیهای کوچکتر با دانهبندی بیشتر است در حالی که مقدار K کوچکتر گروهبندیهای بزرگتر و دانهبندی کمتری دارد. خوشهبندی K-means معمولاً در بخشبندی بازار، خوشهبندی اسناد، تقسیمبندی تصویر و فشردهسازی تصویر استفاده میشود.

خوشهبندی با همپوشانی با خوشهبندی انحصاری تفاوت دارد و به نقاط داده اجازه میدهد به خوشههای متعدد با درجات عضویت جداگانه تعلق داشته باشند. خوشهبندی نرم (Soft) یا k-means فازی، نمونهای از خوشهبندی با همپوشانی است.

خوشهبندی سلسلهمراتبی

خوشهبندی سلسلهمراتبی که به آن تحلیل خوشهی سلسلهمراتبی (Hierarchical Cluster Analysis) یا HCA نیز گفته میشود، یک الگوریتم خوشهبندی بدون ناظر است که میتوان آن را به دو صورت دستهبندی کرد؛ تجمعی (Agglomerative) یا تقسیمی (Divisive). خوشهبندی تجمعی یک “رویکرد پایین به بالا” دارد. نقاط دادهی آن ابتدا به عنوان گروههای جداگانه در نظر گرفته میشوند و سپس به طور مکرر بر اساس شباهت با یکدیگر ادغام میشوند تا زمانی که یک خوشه به دست آید. چهار روش مختلف معمولا برای اندازهگیری شباهت استفاده میشود:

- پیوند Ward: این روش بیان میکند که فاصلهی بین دو خوشه با افزایش در مجموع مجذور پس از ادغام خوشهها تعریف میشود.

- پیوند میانگین: این روش با میانگین فاصلهی بین دو نقطه در هر خوشه تعریف میشود.

- پیوند کامل (یا حداکثری): این روش با حداکثر فاصلهی بین دو نقطه در هر خوشه تعریف میشود.

- پیوند منفرد (یا حداقلی): این روش با حداقل فاصلهی بین دو نقطه در هر خوشه تعریف میشود.

فاصلهی اقلیدسی رایج ترین متریکی است که برای محاسبهی این فاصلهها استفاده میشود. با این حال، معیارهای دیگر، مانند فاصله منهتن نیز در ادبیات خوشهبندی ذکر شدهاند.

خوشهبندی تقسیمی را میتوان به عنوان عکس خوشهبندی تجمعی تعریف کرد. این خوشهبندی یک رویکرد “بالا به پایین” اتخاذ میکند. در این حالت، یک خوشهی واحد بر اساس تفاوت بین نقاط داده تقسیم میشود. خوشهبندی تقسیمی معمولاً مورد استفاده قرار نمیگیرد، اما هنوز به عنوان مثالی در زمینهی خوشهبندی سلسله مراتبی قابل توجه است. این فرآیندهای خوشهبندی معمولاً با استفاده از یک دندروگرام (نمودار درختمانندی که ادغام یا تقسیم نقاط داده در هر تکرار را مستند میکند)، به تصویر کشیده میشوند.

خوشهبندی احتمالی

یک مدل احتمالی یک تکنیک بدون ناظر است که به ما کمک میکند تا تخمین چگالی یا مسائل خوشهبندی “نرم” را حل کنیم. در خوشهبندی احتمالی، نقاط داده بر اساس احتمال تعلق آنها به یک توزیع خاص خوشهبندی میشوند. مدل ترکیبی گاوسی (Gaussian Mixture Model) یا GMM یکی از متداولترین روشهای خوشهبندی احتمالی است.

- مدلهای ترکیبی گاوسی به عنوان مدلهای ترکیبی (Mixture Model) طبقهبندی میشوند، به این معنی که آنها از تعداد نامشخصی از توابع توزیع احتمال تشکیل شدهاند. GMMها در درجهی اول برای تعیین توزیع احتمال گاوسی یا نرمالی که یک نقطه دادهی معین به آن تعلق دارد استفاده میشوند. اگر میانگین یا واریانس مشخص باشد، آنگاه میتوانیم تعیین کنیم که یک نقطه داده معین متعلق به کدام توزیع است. با این حال، در GMMها، این متغیرها شناختهشده نیستند، بنابراین ما فرض میکنیم که یک متغیر پنهان برای خوشهبندی مناسب نقاط داده وجود دارد. در حالی که نیازی به استفاده از الگوریتم بیشینهسازی امید ریاضی (Expectation Maximization) یا EM نیست، معمولاً برای تخمین احتمال انتساب یک نقطه دادهی معین به یک خوشه دادهی خاص استفاده میشود.

قوانین وابستگی

یک قانون وابستگی (Association Rule) یک روش مبتنی بر قوانین برای یافتن روابط بین متغیرها در یک مجموعهدادهی معین است. این روشها اغلب برای تحلیل سبد بازار استفاده میشوند و به شرکتها اجازه میدهند تا روابط بین محصولات مختلف را بهتر درک کنند. درک عادات مصرف مشتریان، کسبوکارها را قادر میسازد تا استراتژیهای فروش متقابل و سیستمهای توصیهگر بهتری را توسعه دهند. نمونههایی از این مورد را میتوان در «مشتریانی که این کالا را خریدند کالای X را نیز خریدند» آمازون یا لیست پخش هفتگی Spotify مشاهده کرد. در حالی که چند الگوریتم مختلف برای تولید قوانین مرتبط وجود دارد، مانند Apriori، Eclat و FP-Growth، الگوریتم Apriori بیشترین استفاده را دارد.

الگوریتم Apriori

الگوریتمهای Apriori از طریق تحلیلهای سبد بازار رایج شدهاند که منجر به سیستمهای توصیهگر مختلف برای پلتفرمهای موسیقی و خردهفروشان آنلاین میشود. از آنها در مجموعهدادههای تراکنشی برای شناسایی مجموعه اقلام رایج، یا مجموعهای از اقلام، برای شناسایی احتمال مصرف یک محصول با توجه به مصرف محصولات دیگر استفاده میشود. به عنوان مثال، اگر من رادیوی Black Sabbath را در Spotify پخش کنم و با آهنگ “Orchid” شروع شود، یکی از آهنگهای دیگر این کانال احتمالاً یک آهنگ Led Zeppelin است، مانند “Over the Hills and Far Away”. این بر اساس عادات گوش دادن قبلی من و دیگران است. الگوریتمهای Apriori از درخت Hash برای شمارش مجموعه آیتمها استفاده میکنند و به روشی گسترده در میان مجموعهدادهها پیمایش میکنند.

کاهش بعد

در حالی که دادههای بیشتر عموماً نتایج دقیقتری به همراه دارد، میتواند بر عملکرد الگوریتمهای یادگیری ماشین نیز تأثیر بگذارد (مثلاً برازش بیش از حد یا overfitting) و همچنین میتواند ترسیم مجموعهدادهها را دشوار کند. کاهش بعد یا Dimentionality Reduction تکنیکی است که زمانی استفاده میشود که تعداد ویژگیها یا ابعاد در یک مجموعهداده بسیار زیاد باشد. این الگوریتمها تعداد ویژگیهای داده را به اندازهی قابل مدیریتی کاهش میدهند و در عین حال یکپارچگی مجموعهداده را تا حد امکان حفظ میکنند. معمولاً در مرحله پیشپردازش دادهها استفاده میشود و چند روش مختلف برای این کار وجود دارد که میتوان از آنها استفاده کرد، مانند:

تحلیل مؤلفههای اصلی

تحلیل مؤلفههای اصلی (Principal Component Analysis) یا PCA نوعی الگوریتم کاهش بعد است که برای کاهش افزونگی (redundancy) و فشردهسازی مجموعهداده از طریق استخراج ویژگی استفاده میشود. این روش از یک تبدیل خطی برای ایجاد یک نمایش جدید از داده استفاده میکند که مجموعهای از “مؤلفههای اصلی” را به خروجی میدهد. اولین جزء اصلی جهتی است که واریانس مجموعه داده را به حداکثر میرساند. در حالی که مؤلفهی اصلی دوم هم حداکثر واریانس را در دادهها پیدا میکند، کاملاً بیارتباط با مؤلفهی اصلی اول است و جهتی عمود یا متعامد به مؤلفه اول ایجاد میکند. این فرآیند بر اساس تعداد ابعاد تکرار میشود، و جزء اصلی بعدی، متعامد به اجزای قبلی با بیشترین واریانس است.

تجزیهی مقدارهای منفرد

تجزیهی مقدارهای منفرد (Singular Value Decomposition) یا SVD یکی دیگر از روشهای کاهش بعد است که یک ماتریس A را به سه ماتریس با رتبهی پایین تبدیل میکند. SVD با فرمول A = USVT نشان داده میشود که در آن U و V ماتریسهای متعامد هستند. S یک ماتریس قطری (diagonal) است و مقادیر آن، مقادیر تکی ماتریس A در نظر گرفته میشوند. مشابه PCA، معمولاً برای کاهش نویز و فشردهسازی دادهها مانند فایلهای تصویری استفاده میشود.

خودرمزگذارها

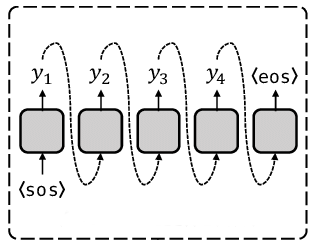

خودرمزگذارها (Autoencoders) از شبکههای عصبی برای فشردهسازی دادهها استفاده میکنند و سپس یک نمایش جدید از دادههای اصلی را دوباره ایجاد میکنند. لایهی پنهان به طور خاص به عنوان یک گلوگاه برای فشردهسازی لایهی ورودی قبل از بازسازی در لایهی خروجی عمل میکند. مرحلهی از لایهی ورودی به لایهی پنهان به عنوان “رمزگذاری” یا encoding و از لایهی پنهان به لایهی خروجی به عنوان “رمزگشایی” یا decoding شناخته میشود.

کاربردهای یادگیری بدون ناظر

تکنیکهای یادگیری ماشین به روشی رایج برای بهبود تجربهی کاربر از محصول و آزمایش سیستمها برای تضمین کیفیت تبدیل شدهاند. یادگیری بدون ناظر یک مسیر اکتشافی برای مشاهدهی دادهها فراهم میکند و به کسبوکارها این امکان را میدهد تا در مقایسه با مشاهدهی دستی، الگوهای حجم زیادی از دادهها را سریعتر شناسایی کنند. برخی از رایجترین کاربردهای یادگیری بدون ناظر در دنیای واقعی عبارتند از:

- بخش اخبار: Google News از یادگیری بدون ناظر برای دستهبندی مقالات مربوط به یک حوزه از رسانههای مختلف خبری آنلاین استفاده میکند. برای مثال، نتایج یک انتخابات ریاست جمهوری را میتوان تحت عنوان اخبار «آمریکا» دستهبندی کرد.

- بینایی ماشین: الگوریتمهای یادگیری بدون ناظر برای کارهای ادراک بصری، مانند تشخیص اشیا استفاده میشود.

- تصویربرداری پزشکی: یادگیری ماشین بدون ناظر ویژگیهای ضروری را برای دستگاههای تصویربرداری پزشکی فراهم میکند، مانند تشخیص تصویر، طبقهبندی و تقسیمبندی، که در رادیولوژی و آسیبشناسی برای تشخیص سریع و دقیق بیماران استفاده میشود.

- تشخیص ناهنجاری: مدلهای یادگیری بدون ناظر میتوانند مقادیر زیادی داده را بررسی کنند و نقاط دادهی غیرمعمول را در یک مجموعهداده کشف کنند. این ناهنجاریها میتوانند آگاهی را در مورد تجهیزات معیوب، خطای انسانی یا نقض امنیت افزایش دهند.

- شخصیتهای مشتری: تعریف شخصیتهای مشتری درک ویژگیهای رایج و عادات خرید مشتریان تجاری را آسانتر میکند. یادگیری بدون ناظر به کسبوکارها اجازه میدهد تا پروفایلهای شخصی بهتری برای خریداران بسازند، و سازمانها را قادر میسازد پیامهای محصول خود را بهطور مناسبتری هماهنگ کنند.

- سیستمهای توصیهگر: با استفاده از دادههای رفتاری در خرید قبلی، یادگیری بدون ناظر میتواند به کشف روندهای دادهای که میتوانند برای توسعه استراتژیهای فروش متقابل مؤثرتر مورد استفاده قرار گیرند، کمک کند. برای مثال، این روش برای ارائهی توصیههای افزودنی مرتبط به مشتریان در طول فرآیند پرداخت برای خردهفروشان آنلاین استفاده میشود.

یادگیری بدون ناظر، یادگیری نظارتشده و یادگیری نیمه نظارتشده

یادگیری بدون ناظر و یادگیری نظارتشده اغلب با یکدیگر مورد بحث قرار میگیرند. برخلاف الگوریتمهای یادگیری بدون ناظر، الگوریتمهای یادگیری نظارتشده از دادههای برچسبدار استفاده میکنند. از این دادهها، یا نتایج آینده را پیشبینی میکند یا بر اساس مسئلهی رگرسیون یا طبقهبندیای که سعی در حل آن دارد، دادهها را به دستههای خاصی اختصاص میدهد. در حالی که الگوریتمهای یادگیری نظارتشده نسبت به مدلهای یادگیری بدون ناظر دقیقتر هستند، اما برای برچسبگذاری دادهها به مداخلهی اولیهی انسانی نیاز دارند. با این حال، این مجموعه دادههای برچسبگذاریشده به الگوریتمهای یادگیری نظارتشده اجازه میدهند تا از پیچیدگی محاسباتی جلوگیری کنند، زیرا به مجموعه آموزشی بزرگی برای تولید نتایج مورد نظر نیاز ندارند. تکنیکهای رگرسیون و طبقهبندی متداول عبارتند از رگرسیون خطی و لجستیک، Naive Bayse، الگوریتم KNN و جنگلهای تصادفی.

یادگیری نیمه نظارتشده زمانی اتفاق میافتد که فقط بخشی از دادههای ورودی برچسب داشته باشند. یادگیری بدون ناظر و نیمه نظارتشده میتوانتد جایگزینهای جذابتری باشد، زیرا تکیه بر تخصص حوزه برای برچسبگذاری مناسب دادهها برای یادگیری نظارتشده میتواند زمانبر و پرهزینه باشد.

برای بررسی عمیق تفاوتهای بین این رویکردها، «یادگیری نظارتشده و یادگیری بدون ناظر؛ تفاوت چیست؟» را بررسی کنید.

چالشهای یادگیری بدون ناظر

در حالی که یادگیری بدون ناظر مزایای بسیاری دارد، زمانی که به مدلهای یادگیری ماشین اجازه میدهد بدون دخالت انسانی اجرا شوند، ممکن است باعث ایجاد برخی چالشها باشد. نمونههایی از این چالشها شامل موارد زیر است:

- پیچیدگی محاسباتی به دلیل حجم بالای دادههای آموزشی

- زمان آموزش طولانیتر

- خطر بالاتر نتایج نادرست

- مداخلهی انسانی برای اعتبارسنجی خروجی

- عدم شفافیت در مورد مبنایی که دادهها بر اساس آن خوشهبندی شدهاند

منبع:

https://www.ibm.com/topics/unsupervised-learning

دیدگاهتان را بنویسید