نقش هوش مصنوعی پیشرفته و تراشهها در تقویت فرایند تشخیص صدا

به نقل از تکاکسپلور، شرکت IBM و دانشگاههای کالیفرنیا در سان فرانسیسکو و برکلی، اخبار خوبی را برای بیمارانی که با مشکلاتی مانند فلج صدا و از دست دادن توانایی گفتار روبرو هستند، ارائه میدهند. این پیشرفت ها در فناوری تشخیص گفتار، امیدوارکنندهاند.

شرکت آیبیام (IBM) اعلام کرده است که توانسته است یک تراشه کامپیوتری با سرعت بالا و کارایی و انرژی بالاتر تولید کند که قادر است بهبود قابل توجهی در خروجی مدلهای تشخیص گفتار را فراهم آورد.

با رشد سریع مدلهای زبانی بزرگ برای پروژههای هوش مصنوعی، محدودیتهای عملکرد سختافزاری که منجر به طولانی شدن دورههای آموزش و مصرف انرژی بیشتر میشود، به وضوح مشخص شده است.

با توجه به مصرف انرژی، مجله MIT Technology Review اخیراً گزارش کرده است که آموزش یک مدل هوش مصنوعی منجر به تولید بیش از ۶۲۶،۰۰۰ پوند دیاکسید کربن میشود، که تقریباً پنج برابر مقداری است که یک خودرو به طور متوسط در طول عمر خود تولید میکند.

یکی از عوامل اصلی مصرف بالای انرژی در عملیات هوش مصنوعی، تبادل دادهها بین حافظه و پردازنده است.

محققان شرکت IBM در جستجوی یافتن راه حلی هستند و میگویند که نمونه اولیه آنها شامل دستگاههای حافظه تغییر فاز درون تراشه است که عملیات اساسی هوش مصنوعی به نام ضرب و جمع (MAC) را بهینه میکند و فعالیت تراشه را به طور قابل توجهی سریعتر میکند. این امر باعث میشود که فرآیند زمانبر و مصرفکننده انرژی انتقال داده بین حافظه و پردازنده نادیده گرفته شود.

Stefano Ambrogia از شرکت IBM در تحقیقی که در تاریخ 23 اوت در ژورنال آنلاین Nature منتشر شده است، اظهار داشت: این تحقیق نمونههایی را ارائه میدهد که بر اساس دقت و کارایی خود، میتوانند در بخش تجاری و صنعتی بهرهبرداری شوند.

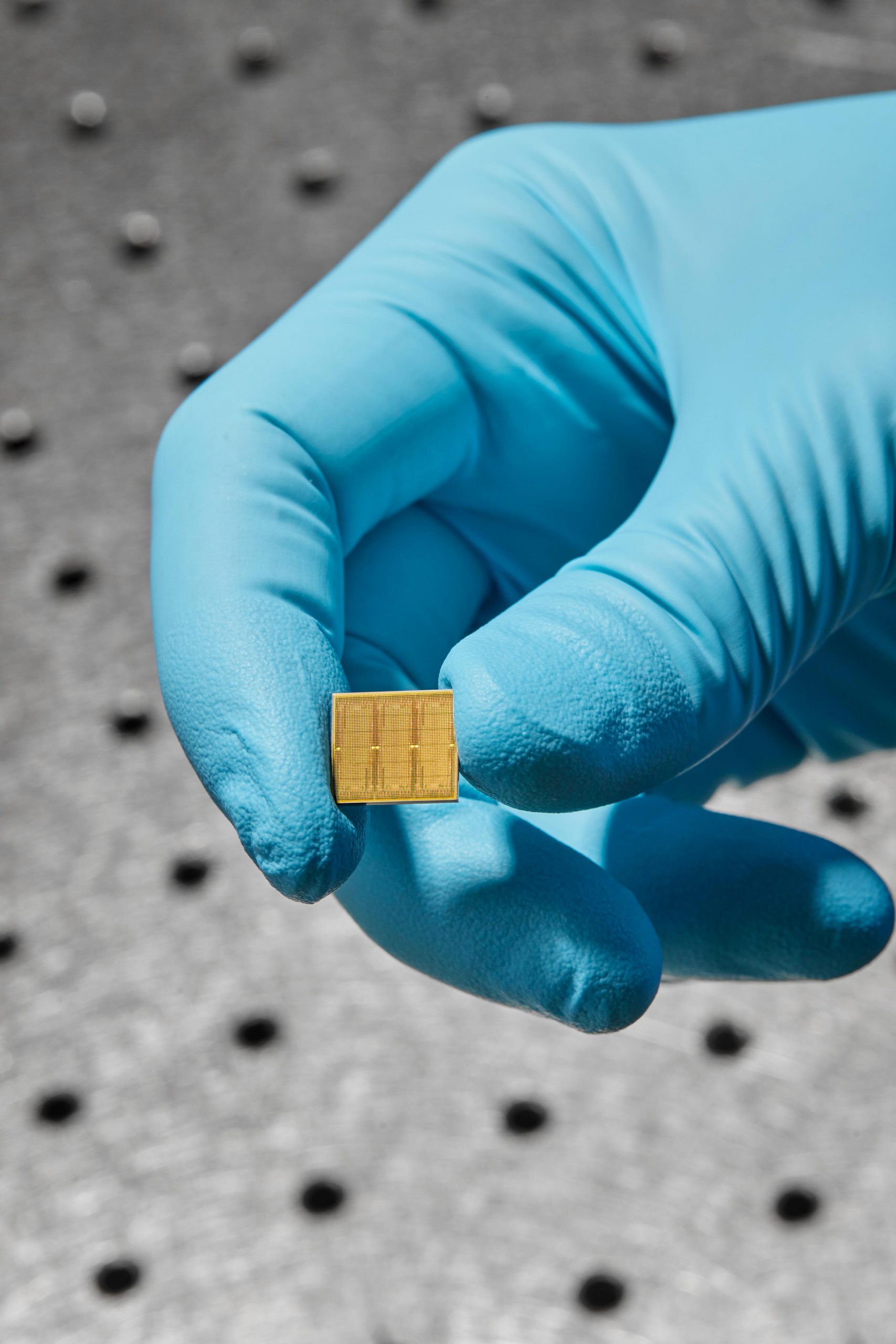

در تصویر، میتوانید یک تراشه هوش مصنوعی آنالوگ را که با استفاده از فناوری 14 نانومتری ساخته شده است، روی یک برد آزمایشی مشاهده کنید. این تصویر توسط رایان لاوین برای شرکت IBM گرفته شده است.

نتایج تحقیقات نشان میدهد که با ترکیب بهینه زمان، فضا و انرژی درون تراشه، میتوان بهبود قابل توجهی در مصرف انرژی و ظرفیت ارسالی سیستمهای هوش مصنوعی آنالوگ داشت. این به این معنی است که با استفاده از روشهای پیشرفتهای برای بهینهسازی زمان، مکان و مصرف انرژی درون تراشه، میتوان کارایی و عملکرد سیستمهای هوش مصنوعی را بهبود بخشید. این پیشرفتها میتوانند منجر به ارتقاء قابل توجه در مصرف انرژی و ظرفیت ارسالی این سیستمها شوند.

که این نتایج میتواند در حوزه صنعتی استفاده شود.

در عملیات شناسایی صوت که نیازمند پردازشهای سنگین هستند، نمونه آزمایشی شرکت IBM توانست در هر وات 12.4 تریلیون عملیات در ثانیه را انجام دهد. این سطح کارآیی به صورت صدها برابر قدرت پردازندههای قویترین واحدهای مربوط به پردازش و گرافیکی که در حال حاضر استفاده میشوند، بهبود چشمگیری را ارائه میدهد.

دراین میان، پژوهشگران دانشگاه UC San Francisco و UC Berkeley یک رابط مغز-کامپیوتر برای افرادی که قدرت صحبت کردن خود را از دست دادهاند، ابداع کردهاند. این رابط قادر است کلمات را بر اساس افکار و تلاشهای کاربر برای صحبت کردن تولید کند.

ادوارد چانگ، رییس بخش جراحی عصبی در دانشگاه UC San Francisco، به این صورت توضیح داد: “هدف ما این است که یک روش کامل و جسمانی برای ارتباط را بازیابی کنیم، که بهترین و طبیعیترین راه برای صحبت کردن با دیگران است.”

چانگ و تیمش دو حسگر کوچک را بر روی سطح مغز یک زنی که به بیماری) ALS سکته عضلانی آمیوتروفیک) مبتلا بود، جراحی کردند. ALS, یک بیماری عصبی است که به طور تدریجی قابلیت حرکت و صحبت کردن را از بیماران می گیرد.

اگرچه این فرد هنوز میتوانست صداها را تولید کند، اما ALS باعث محدود شدن استفاده از لب، زبان و حنجره برای صحبت کردن وی شده بود.

این حسگرها از طریق یک رابط مغز-کامپیوتر به بانکهایی از کامپیوترها متصل شدند که در آنها نرمافزارهایی برای تفسیر زبان نصب شده بود.

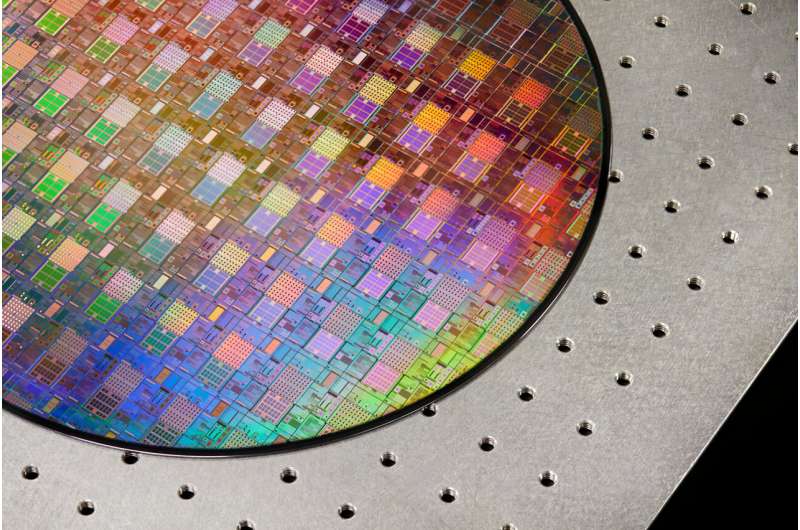

به منظور ساخت تراشههای هوش مصنوعی آنالوگ، از یک وافر با قطر 1300 میلیمتر استفاده میشود. تصویر مربوطه توسط رایان لاوین برای شرکت IBM تهیه شده است.

زن مورد مطالعه(نمونه)، در طی 25 جلسه آموزشی به مدت چهار ساعته ، مجموعههایی شامل بین 260 تا 480 جمله را میخواند. در این جلسات، فعالیت مغزی او در هنگام خواندن توسط دیکودر ترجمه شد و صداها را شناسایی کرد و آنها را به کلمات ترکیب کرد.

پس از آن، پژوهشگران بر اساس ضبطی از صدای زن که در یک مراسم عروسی سالها پیش موجود بود ، گفتار او را ترکیب کردند و یک آواتار طراحی کردند که حرکات صورت او را نمایش میدهد.

پس از چهار ماه آموزش، مدل توانست سیگنال های صدای فرد را _با استفاده از ترکیبی از تکنیکها و الگوریتمهای پردازش سیگنال صوتی و تشخیص گفتار )پیگیری کند و آنها را به کلمات قابل فهم تبدیل کند.

وقتی واژگان آموزشی که تقریباً هرچه فرد مورد مطالعه بخواهد بگوید را پوشش میدهد شامل 125,000 کلمه بود ، نرخ دقت 76٪ بود.

وقتی واژگان محدود به 50 کلمه بود، سیستم ترجمه بهتری داشت و در 90٪ موارد گفتار او را به درستی شناسایی کرد.

سیستم مورد مطالعه توانست با سرعت 62 کلمه در دقیقه، گفتار فرد را ترجمه کند. این نرخ سه برابر نرخ تشخیص کلمات در تست های قبلی بود، اما پژوهشگران بهبودهایی را برای دستیابی به نرخ 160 کلمه در دقیقه، ضروری میدانند.

فرانک ویلت، همکار نویسنده مقاله منتشر شده در تاریخ 23 اوت در نشریه Nature، اظهار داشت: “این یک مفهوم علمی است و نه یک دستگاه واقعی که مردم بتواننددر زندگی روزمره خود استفاده کنند.” او افزود: “اما این یک پیشرفت بزرگ در جهت بازگرداندن ارتباطات سریع برای افرادی است که قادر به صحبت کردن نیستند.”

منبع: https://techxplore.com/news/2023-08-advances-ai-chips-boost-voice.html

دیدگاهتان را بنویسید