آموزش Agent-بخش 6 (تفکر): استدلال داخلی و رویکرد Re-Act

تفکر (Thoughts)

تفکرات نشاندهنده فرآیندهای استدلال و برنامهریزی داخلی Agent برای حل وظیفه هستند.

این از ظرفیت مدل زبانی بزرگ (LLM) Agent برای تحلیل اطلاعات هنگامی که در پرامپت آن ارائه میشود، استفاده میکند.

آن را به عنوان گفتگوی درونی Agent در نظر بگیرید، جایی که وظیفه موجود را بررسی میکند و رویکرد خود را استراتژیسازی میکند.

تفکرات Agent مسئول دسترسی به مشاهدات فعلی و تصمیمگیری درباره اقدام(ات) بعدی هستند.

از طریق این فرآیند، Agent میتواند مشکلات پیچیده را به مراحل کوچکتر و قابل مدیریتتر تقسیم کند، بر تجربیات گذشته تأمل کند و به طور مداوم برنامههای خود را بر اساس اطلاعات جدید تنظیم کند.

در اینجا چند نمونه از تفکرات رایج آورده شده است:

| نوع تفکر | مثال |

|---|---|

| برنامهریزی | “من باید این وظیفه را به سه مرحله تقسیم کنم: ۱) جمعآوری دادهها، ۲) تحلیل روندها، ۳) تولید گزارش” |

| تحلیل | “بر اساس پیام خطا، به نظر میرسد مشکل در پارامترهای اتصال پایگاه داده است” |

| تصمیمگیری | “با توجه به محدودیتهای بودجه کاربر، باید گزینه میانرده را پیشنهاد دهم” |

| حل مسئله | “برای بهینهسازی این کد، ابتدا باید آن را پروفایل کنم تا گلوگاهها را شناسایی کنم” |

| ادغام حافظه | “کاربر قبلاً ترجیح خود برای پایتون را ذکر کرده بود، بنابراین مثالهایی به زبان پایتون ارائه خواهم داد” |

| خودبازتابی | “رویکرد قبلی من خوب کار نکرد، باید استراتژی متفاوتی را امتحان کنم” |

| تعیین هدف | “برای تکمیل این وظیفه، ابتدا باید معیارهای پذیرش را مشخص کنم” |

| اولویتبندی | “آسیبپذیری امنیتی باید قبل از افزودن ویژگیهای جدید برطرف شود” |

توجه: در مورد LLMهایی که برای فراخوانی تابع (function-calling) فاینتیون شدهاند، فرآیند تفکر اختیاری است. در صورتی که با فراخوانی تابع آشنا نیستید، در بخش اقدامات (Actions) جزئیات بیشتری ارائه خواهد شد.

رویکرد Re-Act

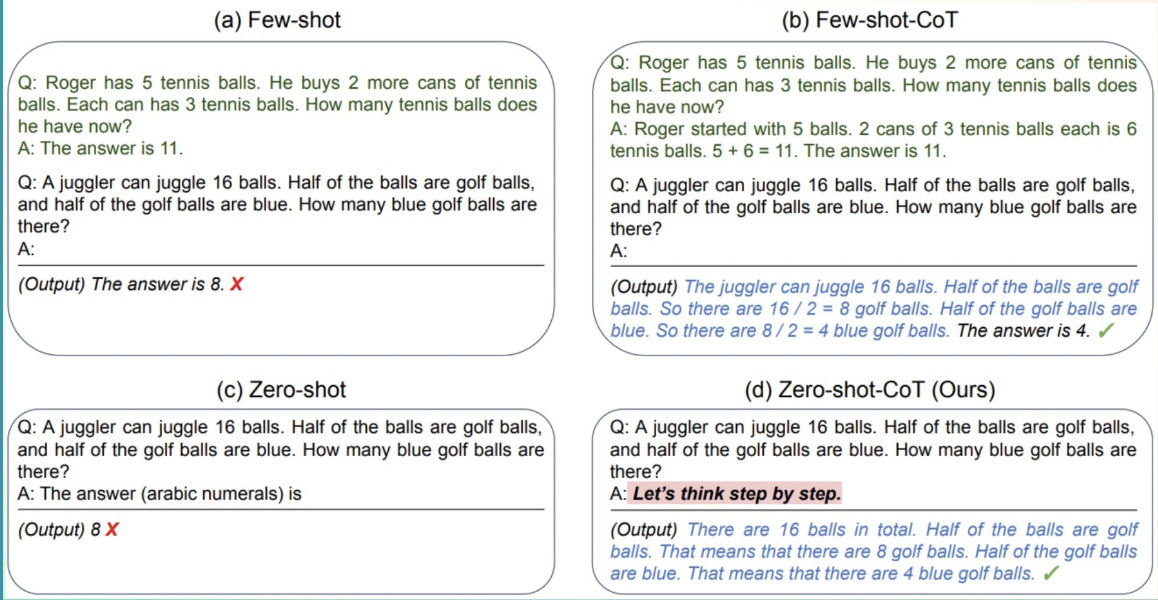

یک روش کلیدی، رویکرد ReAct است که ترکیبی از “استدلال” (Think) با “اقدام” (Act) میباشد.

ReAct یک تکنیک ساده پرامپتدهی است که عبارت “بیایید گام به گام فکر کنیم” را قبل از اجازه دادن به LLM برای رمزگشایی توکنهای بعدی اضافه میکند.

در واقع، پرامپتدهی به مدل برای تفکر “گام به گام” فرآیند رمزگشایی را به سمت توکنهای بعدی که یک برنامه تولید میکنند هدایت میکند، به جای یک راه حل نهایی، زیرا مدل تشویق میشود مسئله را به زیروظایف تجزیه کند.

این به مدل اجازه میدهد زیرمراحل را با جزئیات بیشتری در نظر بگیرد، که به طور کلی منجر به خطاهای کمتری نسبت به تلاش برای تولید مستقیم راه حل نهایی میشود.

ما اخیراً شاهد علاقه زیادی به استراتژیهای استدلال بودهایم. این همان چیزی است که پشت مدلهایی مانند Deepseek R1 یا o1 از OpenAI قرار دارد که برای “اندیشیدن پیش از پاسخگویی” بهینهسازی شدهاند.این مدلها طوری آموزش دیدهاند که همیشه بخشهای مشخصی برای تفکر (بین توکنهای ویژه <think> و </think>) در خروجی خود داشته باشند. این صرفاً یک تکنیک پرامپتدهی مانند ReAct نیست، بلکه روشی آموزشی است که طی آن، مدل با بررسی هزاران نمونه که انتظارات ما را نشان میدهند، میآموزد چگونه این بخشهای تفکر را تولید کند.

حالا که فرآیند تفکر را بهتر درک کردیم، بیایید به بخش دوم این فرآیند یعنی «عمل» عمیقتر بپردازیم. با پست بعدی همراه ما باشید…

دیدگاهتان را بنویسید