آنچه در این دوره میآموزید

به دنیای هوش مصنوعی مولد و مدلهای زبانی بزرگ (LLM) خوش آمدید! در این دوره جامع، شما با تمامی جنبههای LLM آشنا خواهید شد؛ از مبانی هوش مصنوعی مولد و آشنایی کلی با معماری ترنسفورمرها گرفته تا روشهای پیشرفته تنظیم دقیق (Fine-tuning) و استقرار مدلها. این دوره شامل مباحث نظری و عملی فراوان است که به شما کمک میکند دانش خود را در زمینه LLMها به صورت کاربردی توسعه دهید و برای ورود به بازار کار آماده شوید.

با گذراندن این دوره، شما مهارتهای لازم برای ساخت، آموزش و استقرار مدلهای قدرتمند LLM را کسب خواهید کرد و میتوانید پروژههای خلاقانه و کاربردی در این زمینه تعریف و پیادهسازی کنید. این فرصت را از دست ندهید و آینده شغلی خود را در یکی از پرتقاضاترین حوزههای هوش مصنوعی بسازید.

سرفصلهای دوره

- هوش مصنوعی مولد و مدلهای زبانی بزرگ: آشنایی با مفاهیم بنیادین Generative AI و LLMs.

- موارد استفاده و وظایف: بررسی کاربردها و وظایف مختلف LLMs.

- نحوه کار مدلهای زبانی بزرگ - معماری ترنسفورمرها: درک عمیق از ساختار و عملکرد ترنسفورمرها.

- تولید متن با ترنسفورمرها: یادگیری چگونگی تولید متن با استفاده از مدلهای ترنسفورمر.

- پرامپت (پرسشدهی) و مهندسی پرامپت: اصول و تکنیکهای موثر پرامپتنویسی.

- پارامترهای پیکربندی تولیدی برای استنتاج: آشنایی با تنظیمات بهینه برای استنتاج مدل.

- شروع کار با LLM در Google Colab: از Hugging Face تا آمادهسازی دیتاست: راهنمای عملی برای شروع کار در Google Colab.

- مفهوم Tokenization و اجرای Zero-Shot مدل: آشنایی با Tokenization و روش Zero-Shot Inference.

- پروژه خلاصهسازی در پایتون: از Zero تا Few-Shot با LLM و In-Context Learning: پیادهسازی عملی پروژه خلاصهسازی.

- چرخه حیات پروژه هوش مصنوعی مولد: درک مراحل مختلف یک پروژه Generative AI.

- ملاحظات برای انتخاب مدل: معیارهای مهم در انتخاب مدل مناسب.

- معماریهای مدل و اهداف پیشآموزش: بررسی انواع معماریها و اهداف فرآیند Pre-training.

- مدلهای فقط خودرمزگذار (Encoder Only Models): درک عملکرد مدلهای Encoder-Only.

- مدلهای فقط رمزگشا (Decoder Only Models): درک عملکرد مدلهای Decoder-Only.

- مدلهای توالی به توالی (مدلهای رمزگذار-رمزگشا): آشنایی با مدلهای Sequence-to-Sequence.

- رابطه اندازه مدل و دقت: بررسی تأثیر اندازه مدل بر دقت.

- چالشهای محاسباتی و کوانتیزیشن: راهکارهای مقابله با چالشهای محاسباتی و مفهوم Quantization.

- استراتژیهای محاسباتی کارآمد با چند پردازنده گرافیکی (DDP, FSDP): روشهای بهینهسازی محاسبات با GPU.

- قوانین مقیاسپذیری و مدلهای بهینه از نظر محاسباتی: درک اصول Scaling Laws.

- قانون Chinchilla و استثناها: نقش اندازه مدل و داده در عملکرد: بررسی قانون Chinchilla و اهمیت حجم داده.

- پیشآموزش برای انطباق دامنه (Domain Adaptation): تطبیق مدلها با دامنههای خاص.

- تنظیم دقیق یک LLM با استفاده از دستورالعملهای پرامپت: Fine-tuning مدلها بر اساس دستورالعملها.

- Fine-tune کردن روی یک وظیفهی خاص: تنظیم دقیق مدل برای یک وظیفه مشخص.

- Fine-tuning چندوظیفهای و دستوری: Fine-tuning مدل برای چندین وظیفه و دستورالعمل.

- معیارهای ارزیابی مدلهای زبانی (ROUGE, BLEU Score): روشهای ارزیابی کیفیت خروجی مدل.

- بنچمارکها در ارزیابی مدلهای زبان بزرگ (LLM): آشنایی با استانداردهای ارزیابی.

- وظایف Close-ended و بنچمارکها (اختیاری): بررسی وظایف با پاسخ مشخص و بنچمارکهای مرتبط.

- ارزیابی وظایف Open-ended با معیارهای مبتنی بر مدل (اختیاری): روشهای ارزیابی وظایف با پاسخهای آزاد.

- ارزیابی انسانی، چالشها و معیارهای ارزیابی بدون مرجع برای LLMها (اختیاری): اهمیت ارزیابی انسانی و معیارهای جایگزین.

- خودارزیابی مدلهای زبان بزرگ (LLM) با AlpacaEval (اختیاری): کاهش هزینههای ارزیابی با خودارزیابی.

- آشنایی با PEFT: روشهای تنظیم دقیق کارآمد پارامترها: مقدمهای بر PEFT و مزایای آن.

- انطباق کمرتبه مدلهای زبانی بزرگ (LoRA): تکنیک LoRA برای Fine-tuning بهینه.

- تنظیم پرامپت با Soft Promptها: روش Prompt Tuning برای افزایش کارایی.

- نحوه کرایه GPU ابری از Vast.ai: راهنمای استفاده از سرویسهای ابری.

- پیادهسازی فاینتیون مدل هوش مصنوعی مولد برای خلاصهسازی گفتوگو: پروژه عملی Fine-tuning.

- فاینتیون کارآمد پارامترها (PEFT) برای خلاصهسازی گفتوگو: پیادهسازی PEFT در عمل.

- طبقهبندی نظرات IMDB با Gemma2: پروژه عملی طبقهبندی نظرات.

- ترجمه انگلیسی به فارسی با Gemma2-9B: پیادهسازی سیستم ترجمه ماشینی.

- آموزش Prompt Tuning با PEFT: پیادهسازی عملی Prompt Tuning.

- آموزش تولید شعر فارسی با GPT2: ساخت یک مدل تولید شعر فارسی.

- همراستایی مدلها با بازخورد انسانی: مفهوم و اهمیت: درک RLHF و نقش آن.

- مقدمهای بر یادگیری تقویتی: مفاهیم پایه برای مدلهای زبانی: اصول Reinforcement Learning.

- جمعآوری بازخوردهای انسانی: روشهای جمعآوری فیدبک کاربران.

- آموزش مدل پاداش: ساخت و آموزش Reward Model.

- Fine-tune کردن با یادگیری تقویتی با بازخورد انسانی: پیادهسازی Fine-tuning با RLHF.

- بهینهسازی خطمشی نزدیک (PPO) (اختیاری): بررسی عمیق الگوریتم PPO.

- Policy Loss در PPO (اختیاری): درک مؤلفه Policy Loss.

- درک Value Loss و Entropy Loss در RLHF (اختیاری): تحلیل مؤلفههای دیگر Loss در RLHF.

- بررسی Reward Hacking و کنترل با KL Divergence: مقابله با مشکلات Reward Hacking.

- آموزش RLHF با FLAN-T5: پیادهسازی RLHF برای خلاصهسازی دیالوگ.

- بهینهسازی مستقیم ترجیحات (DPO): بررسی الگوریتم DPO.

- آموزش DPO با Qwen: پیادهسازی DPO برای تولید عناوین ویدیو.

- DPO با Phi-3: پیادهسازی DPO برای پاسخ دقیق به سوالات محاسباتی.

- بهینهسازی سیاست نسبی گروهی (GRPO): معرفی الگوریتم GRPO.

- انتخاب بین PPO، DPO و GRPO: راهنمای انتخاب بهترین الگوریتم.

- درک عمیق الگوریتم GRPO (اختیاری): تحلیل پیشرفته GRPO.

- مثال ساده فاینتیون LLM با روش GRPO برای محدود کردن طول جمله: پیادهسازی GRPO برای کنترل خروجی.

- زنجیره افکار (COT): تکنیک Chain-of-Thought برای بهبود استدلال مدل.

- فاینتیون مدل زبانی بزرگ با LoRA و Unsloth: بهینهسازی Fine-tuning با Unsloth.

- مقیاسپذیر کردن بازخورد انسانی: روشهای مقیاسگذاری فیدبک.

- بهینهسازی مدل با هدف افزایش بهرهوری برنامه کاربردی: اهمیت بهینهسازی برای عملکرد بهتر.

- تقطیر دانش (Knowledge Distillation): کاهش اندازه مدل بدون کاهش چشمگیر عملکرد.

- کوانتیزیشن و هرس مدل (Model Quantization & Pruning): تکنیکهای بهینهسازی مدل.

- هرس مدلهای زبان بزرگ در عمل (اختیاری): پیادهسازی عملی Pruning.

- پیادهسازی تقطیر دانش برای LLMها: پروژه عملی Knowledge Distillation.

- استفاده از مدل زبانی بزرگ در برنامهها: کاربرد LLMها در اپلیکیشنهای واقعی.

- تولید متن تقویتشده از طریق بازیابی اطلاعات (RAG): بهبود تولید متن با بازیابی اطلاعات.

- آمادهسازی دادهها برای پایگاه برداری در مدل RAG: آمادهسازی دیتاست برای RAG.

- آشنایی با امبدینگ جمله بهصورت عملی: درک و کاربرد Sentence Embeddings.

- RAG با LangChain: ساخت اپلیکیشنهای پرسشوپاسخ با LangChain.

- امکانپذیر ساختن تعامل با برنامههای خارجی: قابلیت ارتباط LLM با سیستمهای بیرونی.

- کمک به LLM برای استدلال و برنامهریزی با استفاده از روش «زنجیره تفکر»: تکنیک Chain-of-Thought برای بهبود منطق مدل.

- مدلهای زبانی تقویتشده با برنامهنویسی (PAL): استفاده از تولید کد برای حل مسائل.

- حل مسائل ریاضی با تولید کد پایتون توسط مدل Mistral (به روش PAL): پروژه عملی PAL.

- ReAct: ترکیب استدلال و اقدام در مدلهای زبانی بزرگ: چارچوب ReAct برای LLMها.

- ساخت Agent با LangChain و مدل Qwen2.5 برای جستجوی زنده با DuckDuckGo: ساخت Agent با قابلیت جستجو در وب.

- جمعبندی نهایی و ادامه مسیر یادگیری: نکات پایانی و راهنمایی برای ادامه مسیر.

این فصل به زودی منتشر میگردد...

درباره دوره

درس «هوش مصنوعی مولد با مدلهای زبانی بزرگ (LLM)» یک دوره آموزشی جامع است که به معرفی مفاهیم، روشها و کاربردهای مدلهای زبانی پیشرفته میپردازد. این مدلها در قلب ابزارهایی مانند ChatGPT، Gemini و Grok قرار دارند و در طیف گستردهای از کاربردها از جمله تولید متن، پاسخ به سوالات، ترجمه ماشینی، خلاصهسازی خودکار و حتی برنامهنویسی خودکار به کار میروند.

در این دوره ابتدا ساختار مدلهای زبانی و مفاهیم پایهای مانند زبان طبیعی، توکنسازی، ترنسفورمر و attention آموزش داده میشود. سپس مسیر آموزش این مدلها از مرحله پیشتمرین (pretraining) تا ریزتنظیم (fine-tuning) بررسی میشود. پس از آن مفاهیم پیشرفتهتری مانند instruction tuning، RLHF (یادگیری تقویتی از بازخورد انسانی)، و روشهای جدیدتر مانند DPO (Direct Preference Optimization) و GRPO (General Reward Policy Optimization) معرفی و پیادهسازی میشوند.

یکی از ویژگیهای برجسته این دوره، ارائهی حدود 20 نوتبوک آموزشی و پروژهمحور است که شامل مثالهای کاربردی (از جمله مثالهایی در زبان فارسی) و کدهای قابل اجرا هستند. این ساختار به یادگیری عمیقتر و درک بهتر مفاهیم کمک میکند.

پیشنیاز شرکت در این دوره، آشنایی اولیه با زبان پایتون و مفاهیم پایهی یادگیری ماشین و شبکههای عصبی است. آشنایی با کتابخانههایی مانند PyTorch یا TensorFlow نیز بسیار مفید است، اما ضروری نیست.

این دوره مناسب دانشجویان، پژوهشگران، مهندسان نرمافزار، علاقهمندان به هوش مصنوعی و توسعهدهندگان NLP است و میتواند زمینهساز فعالیتهای پژوهشی یا کاربردی در حوزه مدلهای زبانی بزرگ به زبان فارسی یا انگلیسی باشد.

این دوره LLM چیست و چه چیزی به شما نمیدهد

این دوره LLM قراره مسیر یادگیری مدلهای زبانی بزرگ رو به شکل عملی و پروژهمحور بهت نشون بده.

اینجا آموزش صفر تا صد معماری ترنسفورمر یا RAG و Agentic AI به شکل جامع نیست، اما پایههای Self-Attention، ساختارهای مهم ترنسفورمر، ایدهی Retrieval-Augmented Generation و نمونههایی مثل ReAct و PAL با کد عملی مرور میشه.

تمرکز دوره روی مباحث بنیادین و ضروری LLM است: از pretraining و fine-tuning تا RLHF و ساخت اپلیکیشن واقعی، با مثالهای فارسی و پروژههای عملی که تجربه کاربردی رو بهت میده. این دوره مخصوص کساییه که میخوان دنیای LLM رو بفهمن، دنبال پیادهسازی هستن، و حتی بدون تجربه زیاد در شبکههای عصبی هم میتونن مسیر یادگیری رو دنبال کنن.

مخاطبان دوره

مخاطبان این دوره کسانی هستند که میخواهند دنیای مدلهای زبانی بزرگ (LLM) را بهصورت کاربردی و عملی تجربه کنند. این دوره برای افرادی مناسب است که دنبال پیادهسازی و پروژههای واقعی هستند، نه فقط تئوری خشک، و حتی اگر تجربه کمی در شبکههای عصبی دارند، با کمی تلاش میتوانند مفاهیم را دنبال کنند. همچنین برای توسعهدهندگان، دانشجویان و پژوهشگرانی طراحی شده که میخواهند از مقدمات تا ساخت اپلیکیشنهای واقعی با LLM پیش روند و مهارتهای روز فاینتیونینگ، RLHF و کار با دادههای واقعی را یاد بگیرند.

مزیت های این دوره

این دوره با جدیدترین متدها و ابزارهای LLM مثل DPO و GRPO بهروز شده و ترکیبی از آموزش عملی و تئوری را ارائه میدهد. با مثالهای فارسی واقعی، یادگیری شما کاربردی و ملموس خواهد بود. علاوه بر این، محتوا بهطور مداوم بهروزرسانی میشود تا شما همیشه با آخرین تکنیکها و رویکردهای روز در دنیای مدلهای زبانی بزرگ همراه باشید.

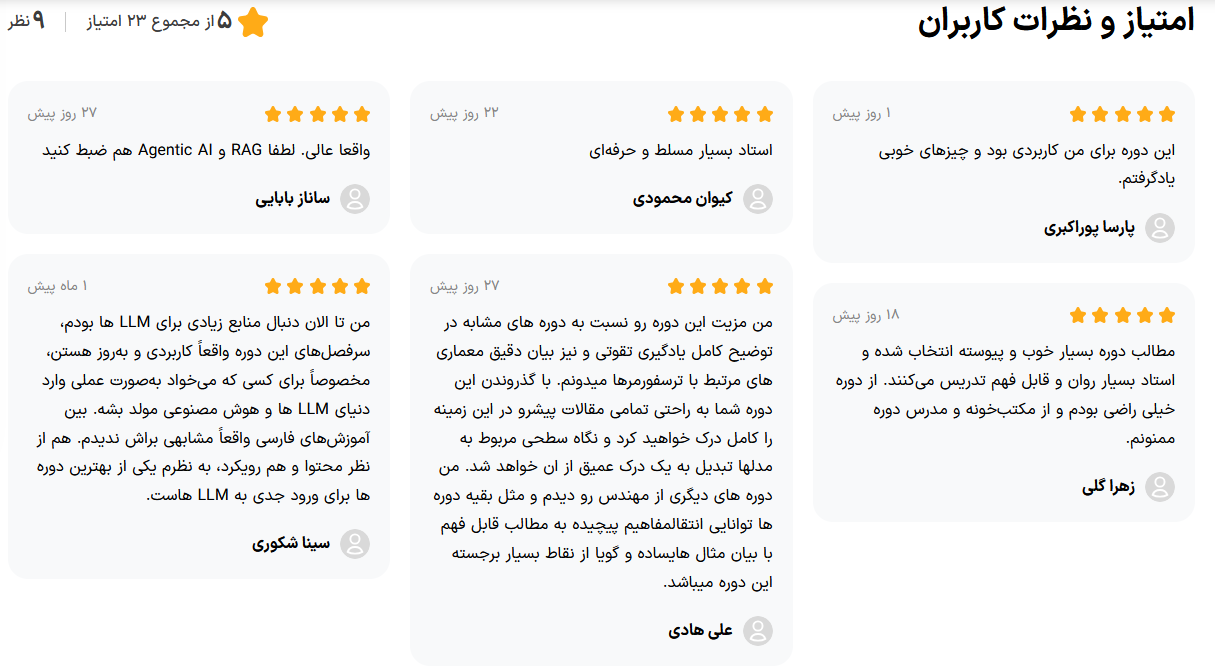

نظر دانشجویان دوره

کدها و اسلایدها

کدهای مربوط به تمامی مباحث عملی و پروژههای این دوره در گیتهاب موجود است. شما میتوانید با مراجعه به لینک زیر، به تمامی سورس کدها دسترسی پیدا کنید و تمرینات را به صورت عملی انجام دهید:

این دوره فرصتی بینظیر برای عمق بخشیدن به دانش و مهارتهای شما در زمینه LLM است. برای ثبتنام و شروع یادگیری، روی دکمه زیر کلیک کنید:

همین حالا در دوره ثبتنام کنید!

با شرکت در دوره جامع مدلهای زبانی بزرگ، از جدیدترین تکنولوژیهای هوش مصنوعی بهرهمند شوید. این دوره شامل مباحث پیشرفته هوش مصنوعی مولد، ترنسفورمرها، فاینتیونینگ، RLHF، PEFT و استقرار LLMها است. یادگیری ساختار ترنسفورمرها، مهندسی پرامپت، و روشهای بهینهسازی مدلها برای استقرار کارآمد از جمله سرفصلهای کلیدی این دوره است. به جامعه متخصصان LLM بپیوندید و مهارتهای لازم برای ساخت Chatbot، سیستمهای RAG و Agentهای هوشمند را کسب کنید.

کانال تلگرامی دوره LLM & Hugging Face

اعلان جلسات، اسلایدها، کدها و نکات تکمیلی دوره

- آخرین تمرینها و ریلیز کدها را دریافت کنید

- اطلاعیههای کلاس و بهروزرسانی سرفصلها را سریع ببینید

- پرسشوپاسخهای کوتاه و نکات عملی را دنبال کنید

https://t.me/llm_huggingface

با لمس/کلیک دکمه بالا، تلگرام باز میشود. اگه باز نشد، آدرس را کپی کنید.

قوانین ثبت دیدگاه